cognee - Mémoire pour Agents IA en 5 lignes de code

Demo . Learn more · Join Discord · Join r/AIMemory

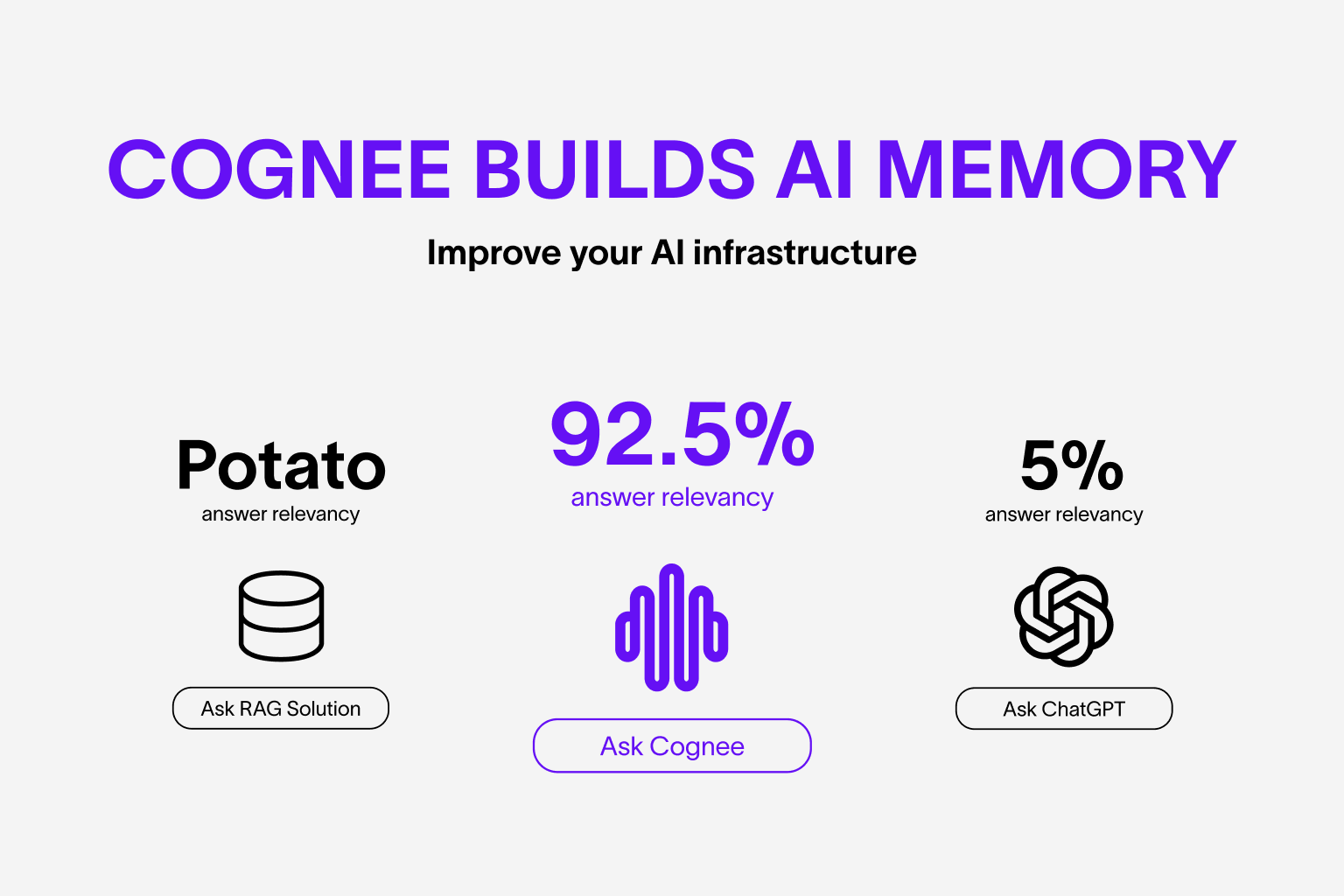

Construisez une mémoire dynamique pour les Agents et remplacez RAG en utilisant des pipelines ECL (Extract, Cognify, Load) modulaires et évolutifs.

Plus d'informations sur les cas d'utilisation et les évaluations

🌐 Available Languages : Deutsch | Español | français | 日本語 | 한국어 | Português | Русский | 中文

Fonctionnalités

- Interconnectez et récupérez vos conversations passées, documents, images et transcriptions audio

- Remplace les systèmes RAG et réduit l'effort des développeurs ainsi que les coûts.

- Chargez des données dans des bases de données graphes et vectorielles en utilisant uniquement Pydantic

- Manipulez vos données lors de l'ingestion à partir de 30+ sources de données

Premiers pas

Commencez rapidement avec un notebook Google Colab notebook, un Deepnote notebook ou un dépôt de démarrage

Contributions

Vos contributions sont au cœur de ce véritable projet open source. Toute contribution est grandement appréciée. Consultez CONTRIBUTING.md pour plus d'informations.

📦 Installation

Vous pouvez installer Cognee en utilisant pip, poetry, uv ou tout autre gestionnaire de paquets Python. Cognee prend en charge Python 3.8 à 3.12

Avec pip

pip install cognee

Installation locale de Cognee

Vous pouvez installer le dépôt local de Cognee en utilisant pip, poetry et uv. Pour une installation locale avec pip, assurez-vous que votre version de pip est supérieure à la version 21.3.

avec UV avec toutes les dépendances optionnelles

uv sync --all-extras

💻 Utilisation de base

Configuration

import os

os.environ["LLM_API_KEY"] = "YOUR OPENAI_API_KEY"

Vous pouvez également définir les variables en créant un fichier .env, en utilisant notre modèle. Pour utiliser différents fournisseurs de LLM, pour plus d'informations, consultez notre documentation

Exemple simple

Ce script exécutera le pipeline par défaut :

import cognee

import asyncio

async def main():

# Add text to cognee

await cognee.add("Natural language processing (NLP) is an interdisciplinary subfield of computer science and information retrieval.")

# Generate the knowledge graph

await cognee.cognify()

# Query the knowledge graph

results = await cognee.search("Tell me about NLP")

# Display the results

for result in results:

print(result)

if __name__ == '__main__':

asyncio.run(main())

Exemple de sortie :

Natural Language Processing (NLP) is a cross-disciplinary and interdisciplinary field that involves computer science and information retrieval. It focuses on the interaction between computers and human language, enabling machines to understand and process natural language.

Notre article est publié ! Lisez-le ici

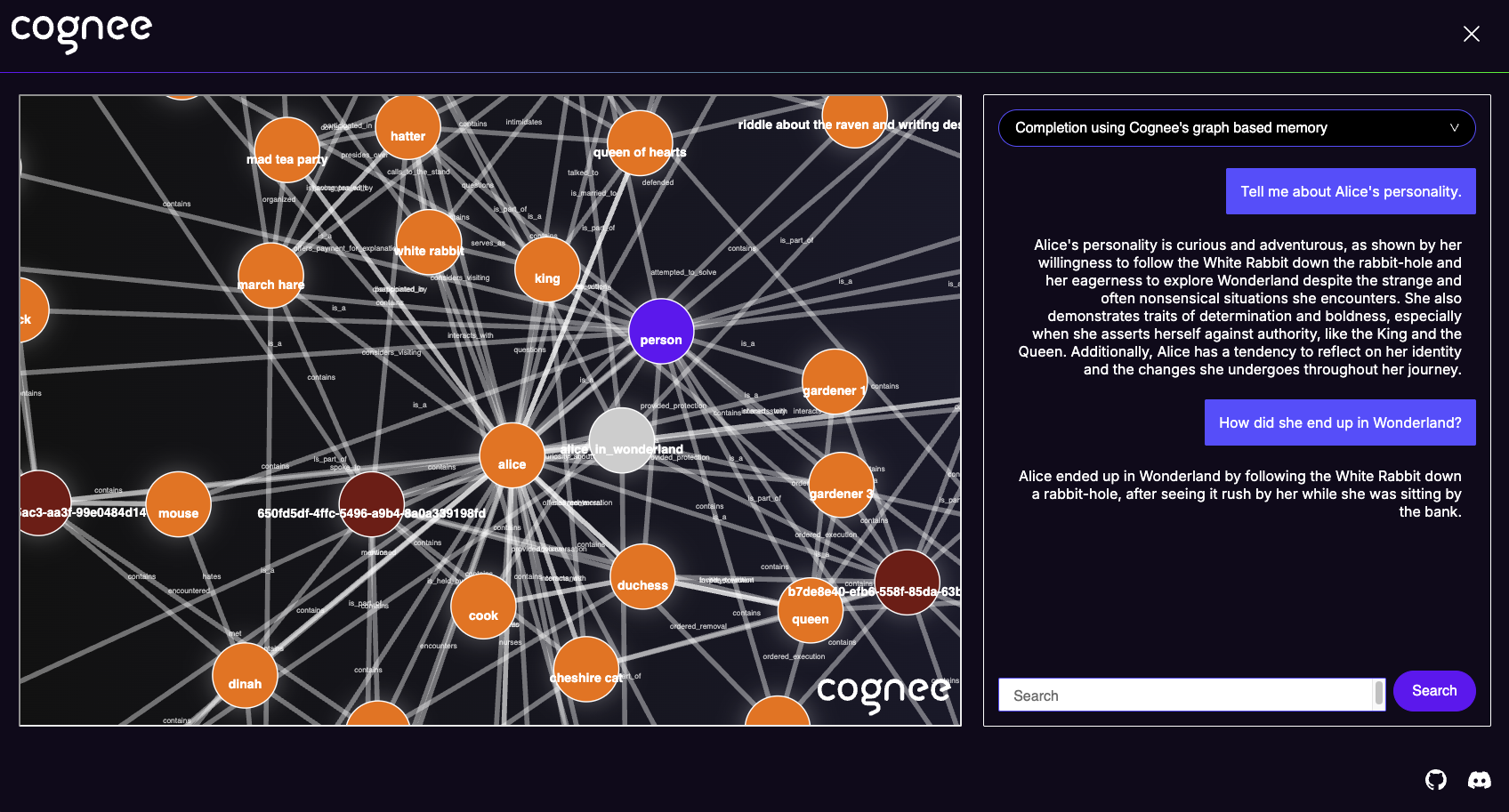

Interface utilisateur Cognee

Vous pouvez également cognifier vos fichiers et interroger en utilisant l'interface utilisateur Cognee.

Essayez l'interface utilisateur Cognee localement ici.

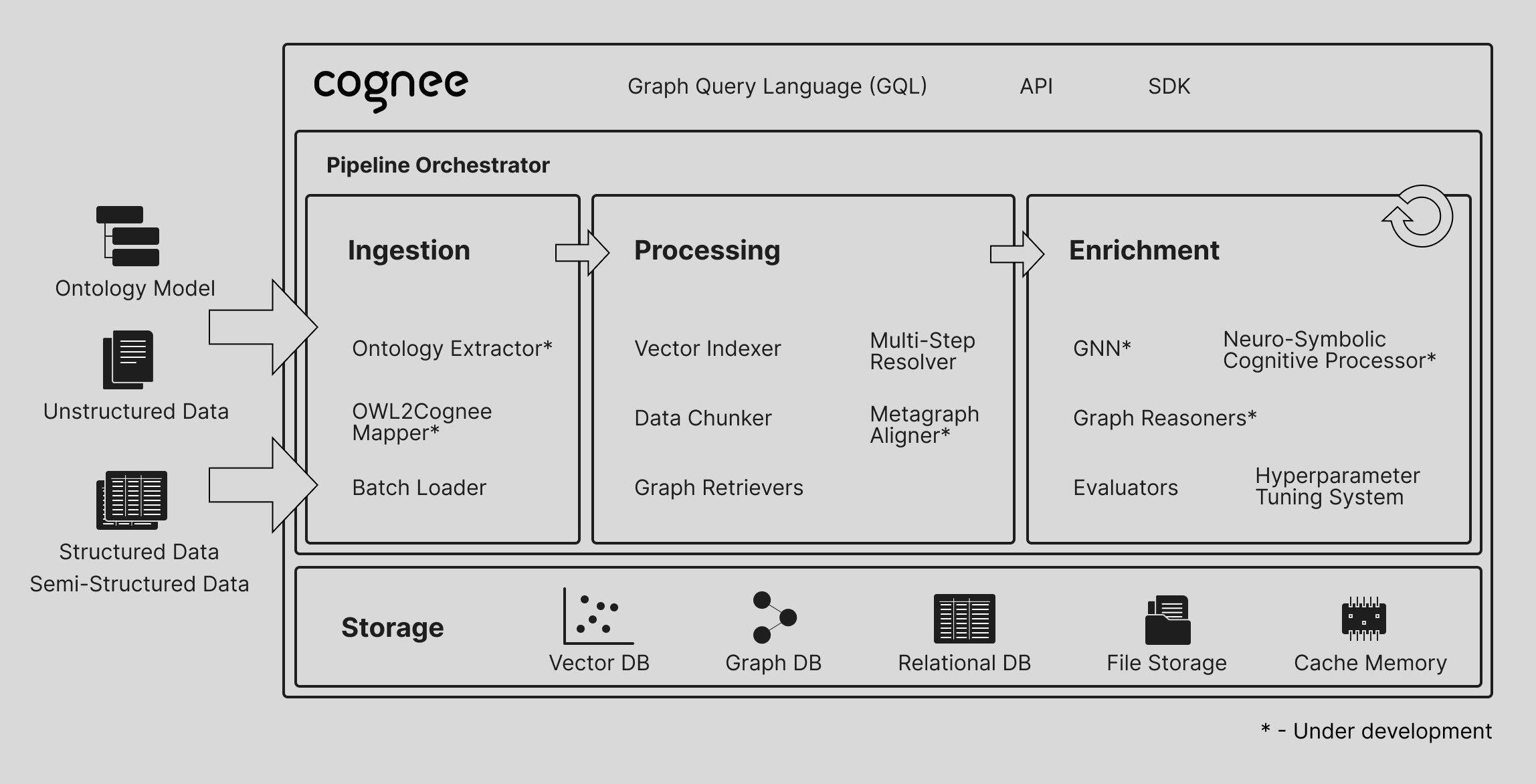

Comprendre notre architecture

Démonstrations

- Qu'est-ce que la mémoire IA :

- Démo simple de GraphRAG

- cognee avec Ollama

Code de conduite

Nous nous engageons à faire de l'open source une expérience agréable et respectueuse pour notre communauté. Consultez CODE_OF_CONDUCT pour plus d'informations.