cognee - Speicher für KI-Agenten in 5 Codezeilen

Demo . Learn more · Join Discord · Join r/AIMemory

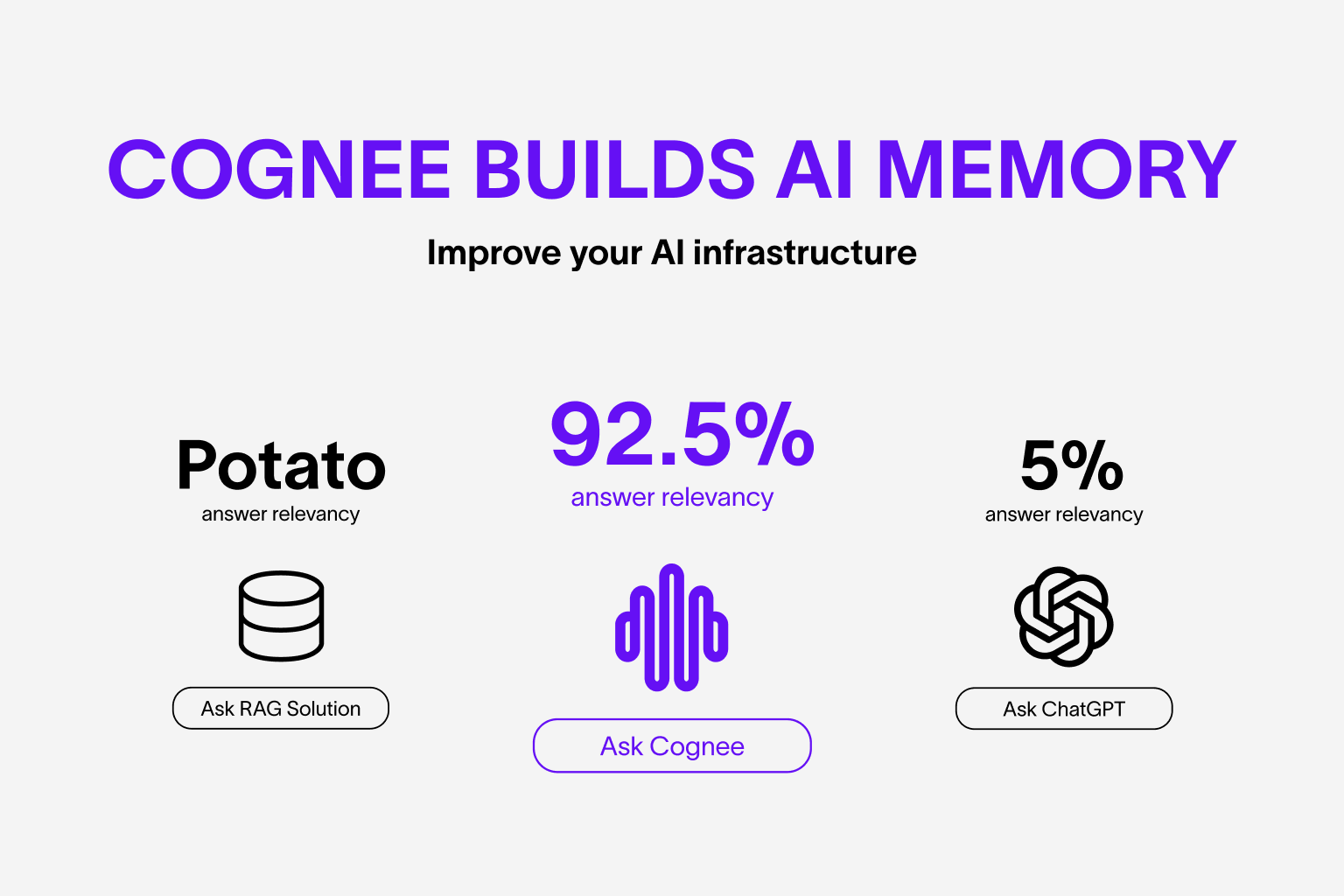

Erstellen Sie dynamischen Speicher für Agenten und ersetzen Sie RAG durch skalierbare, modulare ECL-Pipelines (Extract, Cognify, Load).

Mehr zu Anwendungsfällen und Evaluierungen

🌐 Available Languages : Deutsch | Español | français | 日本語 | 한국어 | Português | Русский | 中文

Funktionen

- Verknüpfen und abrufen Sie Ihre früheren Konversationen, Dokumente, Bilder und Audiotranskriptionen

- Ersetzt RAG-Systeme und reduziert Entwicklungsaufwand und Kosten.

- Laden Sie Daten in Graph- und Vektordatenbanken mit nur Pydantic

- Bearbeiten Sie Ihre Daten während des Imports aus 30+ Datenquellen

Erste Schritte

Steigen Sie schnell mit einem Google Colab notebook, Deepnote notebook oder Starter-Repository ein.

Mitwirken

Ihre Beiträge sind der Kern dieses echten Open-Source-Projekts. Jeder Beitrag wird sehr geschätzt. Weitere Informationen finden Sie in CONTRIBUTING.md.

📦 Installation

Sie können Cognee mit pip, poetry, uv oder einem anderen Python-Paketmanager installieren. Cognee unterstützt Python 3.8 bis 3.12.

Mit pip

pip install cognee

Lokale Cognee-Installation

Sie können das lokale Cognee-Repository mit pip, poetry oder uv installieren. Für die lokale pip-Installation stellen Sie bitte sicher, dass Ihre pip-Version über Version 21.3 liegt.

Mit UV und allen optionalen Abhängigkeiten

uv sync --all-extras

💻 Grundlegende Verwendung

Einrichtung

import os

os.environ["LLM_API_KEY"] = "YOUR OPENAI_API_KEY"

Sie können die Variablen auch durch Erstellen einer .env-Datei festlegen, indem Sie unsere Vorlage verwenden. Um verschiedene LLM-Anbieter zu nutzen, finden Sie weitere Informationen in unserer Dokumentation.

Einfaches Beispiel

Dieses Skript führt die Standard-Pipeline aus:

import cognee

import asyncio

async def main():

# Add text to cognee

await cognee.add("Natural language processing (NLP) is an interdisciplinary subfield of computer science and information retrieval.")

# Generate the knowledge graph

await cognee.cognify()

# Query the knowledge graph

results = await cognee.search("Tell me about NLP")

# Display the results

for result in results:

print(result)

if __name__ == '__main__':

asyncio.run(main())

Beispielausgabe:

Natural Language Processing (NLP) is a cross-disciplinary and interdisciplinary field that involves computer science and information retrieval. It focuses on the interaction between computers and human language, enabling machines to understand and process natural language.

Unser Paper ist veröffentlicht! Hier lesen

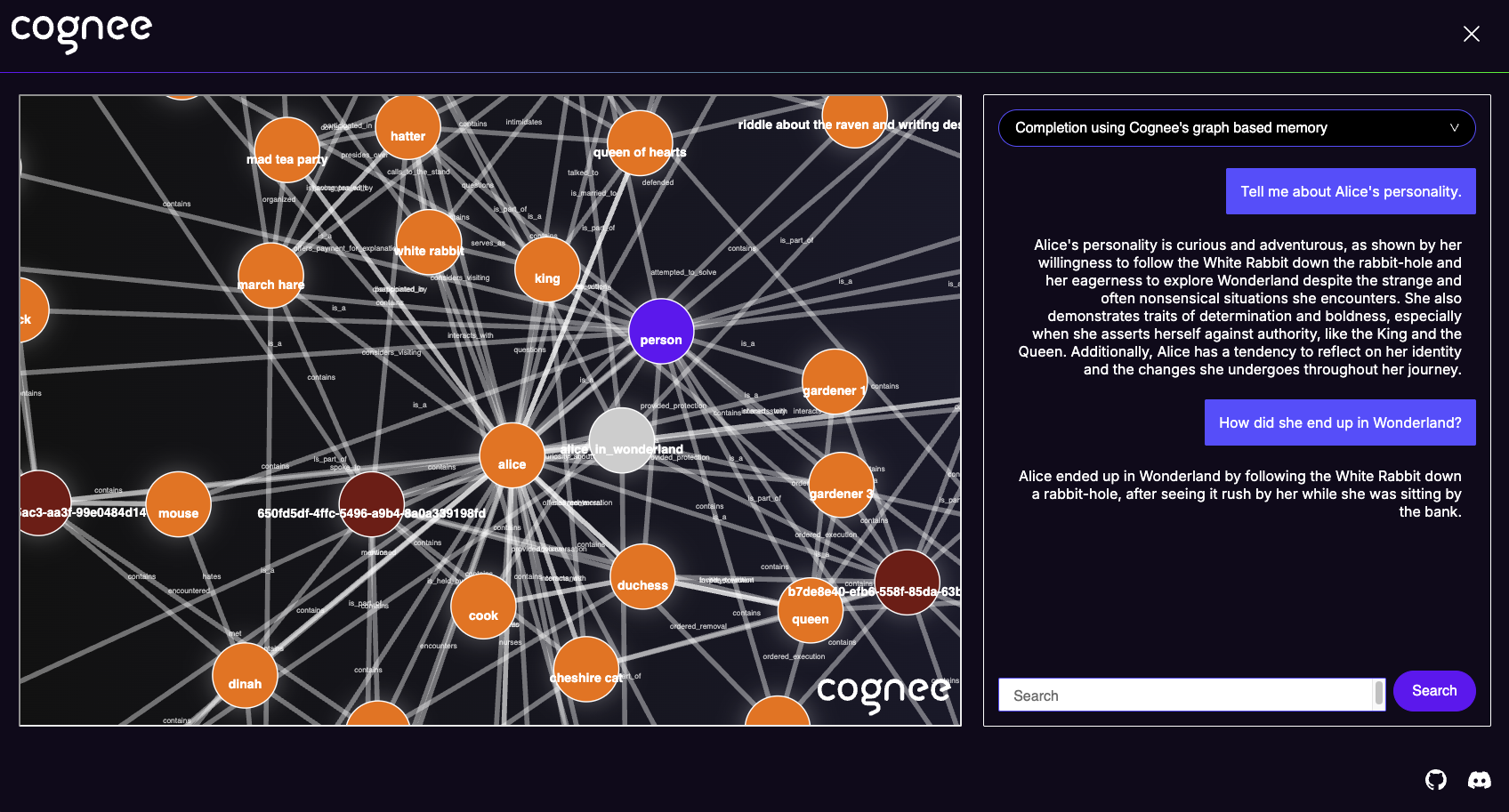

Cognee UI

Sie können auch Ihre Dateien cognifizieren und mit der Cognee UI abfragen.

Probieren Sie die Cognee UI lokal aus hier.

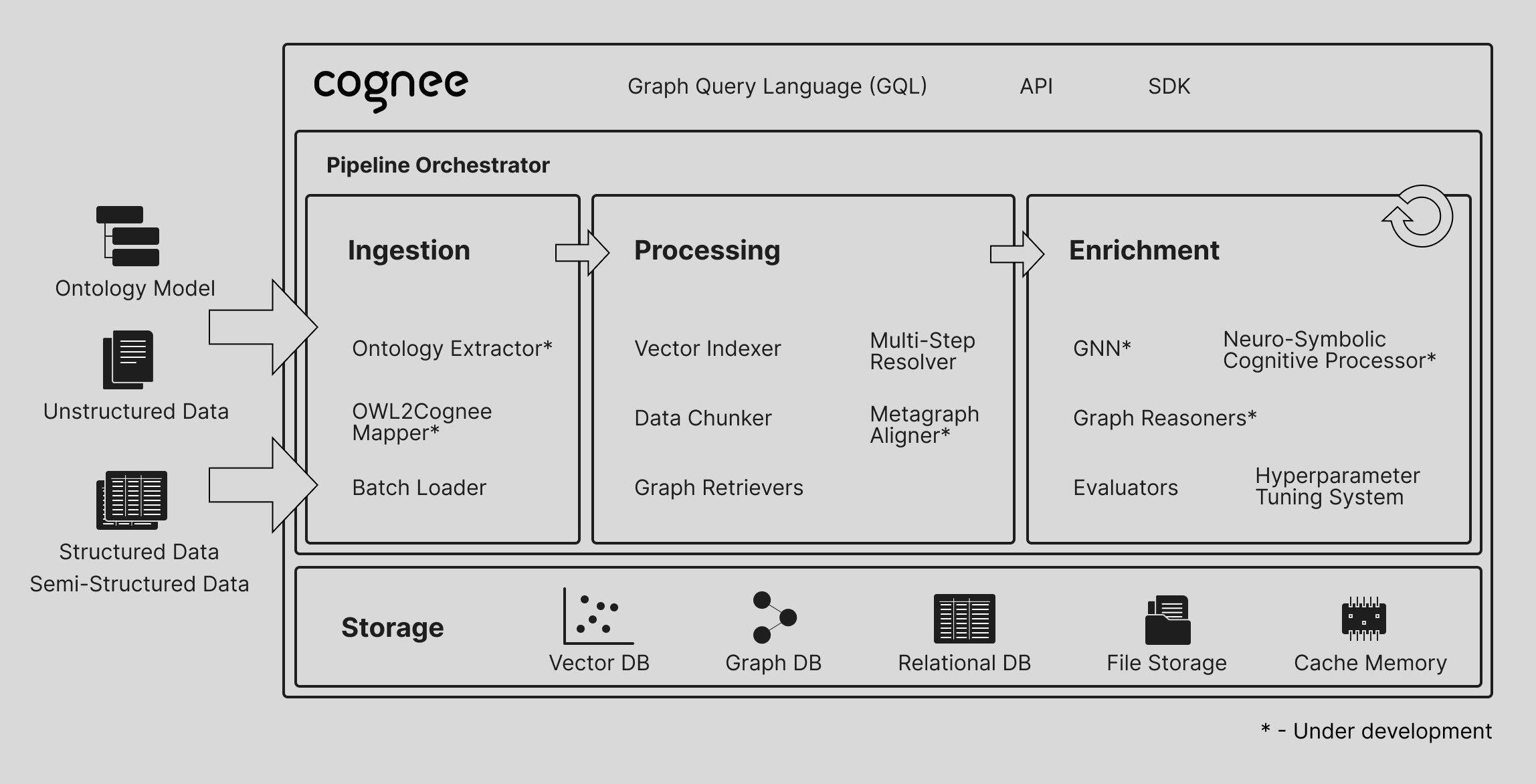

Verstehen Sie unsere Architektur

Demos

- Was ist KI-Speicher:

- Einfache GraphRAG-Demo

- cognee mit Ollama

Verhaltenskodex

Wir sind bestrebt, Open Source zu einer angenehmen und respektvollen Erfahrung für unsere Community zu machen. Weitere Informationen finden Sie unter CODE_OF_CONDUCT.